AMD Schola

AMD Schola 是一个用于在 Unreal Engine 中开发强化学习 (RL) 代理并使用您喜欢的 Python 基础 RL 框架进行训练的库。

如果您能够将尖端的强化学习(RL)算法直接集成到您的游戏项目中——无需冗长的变通方法或从头开始重建环境——那会怎么样?

AMD Schola 将使之成为现实。通过连接流行的开源 RL 库(用 Python 编写)和虚幻引擎的视觉和物理能力,Schola 使 AI 研究人员和游戏开发者都能突破智能游戏体验的界限。

AI 研究人员通常在孤立的模拟环境或库中开发复杂的 RL 算法,但在将这些解决方案移植到实际游戏中时会遇到挑战。

与此同时,旨在为非玩家角色(NPC)添加智能行为的游戏开发者通常必须从头开始——创建新的 AI 逻辑,或尝试复杂集成,而文档却很少。

它减缓了创新:有前途的研究仍然局限于学术界。

它增加了复杂性:开发者必须复制算法,或将其他地方训练好的模型塞入现有游戏机制,导致结果不尽如人意。

想象一款带有 NPC 守卫的潜行游戏,开发者必须在守卫始终确切地知道玩家在哪里(使游戏困难且不现实)和几乎没有警惕性(使其过于容易)之间取得艰难的平衡。

借助 Schola,这些守卫可以学会逼真的行为——例如有条不紊地搜寻玩家,或智能地响应可疑事件。这个灵活的 AI 开发工具包将游戏性从可预测变为身临其境。

更具吸引力的 NPC:NPC 实时适应玩家的行为,带来动态游戏玩法,让玩家保持投入。

更快的原型制作:借助 Schola,您可以试验各种 RL 驱动的行为,并在虚幻编辑器中快速测试它们。

直接虚幻集成:利用虚幻引擎的高级物理、渲染和资产库。

简化的工作流程:不再需要拼凑原型并移植它们。在您将用于最终部署的同一环境中训练、测试和优化 RL 算法。

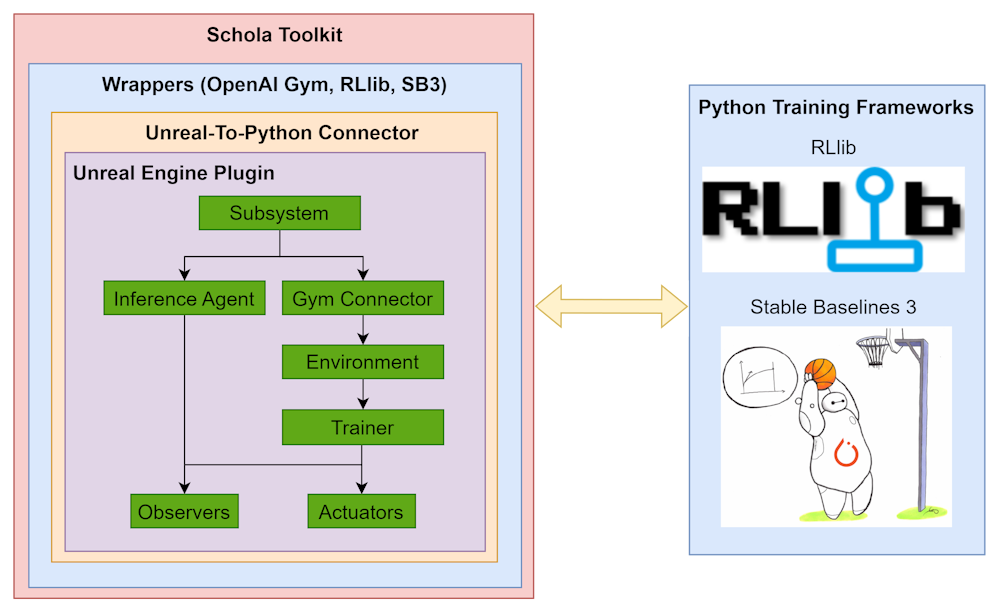

Schola 支持两种流行的开源 RL 库(RLlib 和 Stable-Baselines3)以及 Gymnasium API,对于熟悉这些工具的任何人来说都非常易于上手。它提供

多种 RL 库集成:无需学习新 API,即可无缝切换或组合您最喜欢的 RL 框架。

即时虚幻引擎兼容性:所有训练、测试和调试都可以在虚幻丰富的生态系统中直接进行——无需重建环境。

易于设置和文档:我们的在线 API 文档将指导您完成 Schola 的安装和使用过程,以便您可以更快地开始训练您的模型。

如果您想一窥 Schola 的实际应用,请查看我们的 示例。您将看到 RL 模型如何创造更自然的行为和动作。

下面的技术设计图详细说明了 Schola 如何与虚幻引擎和 RL 库进行通信。

我们提供多种方式供您探索 Schola,每种方式都适合不同程度的兴趣或专业知识。

安装插件

尝试我们的示例环境

探索我们的文档

贡献和参与

通过融合开源 RL 工具和虚幻引擎的优势,Schola 为游戏中的下一代 AI 开辟了新的途径。研究人员可以专注于优化算法,而开发者可以轻松地实现它们,以获得更具沉浸感和适应性的游戏体验。

请继续关注新功能、指南和示例,以不断提升您构建沉浸式 AI 的能力!

加入 GitHub 社区,并帮助塑造 AI 驱动 NPC 的未来。

我们迫不及待地想看到您将用 Schola 创造出的开创性想法和智能游戏世界。